Rapport de la transparence Discord – 1 janvier – 1 avril

TardiGab • Publié le 1 September 2019

traductionsIl y a quelques mois, nous avons promis de poursuivre la conversation sur la confiance et la sécurité ici chez Discord. Aujourd'hui, nous sommes fiers de vous présenter notre tout premier rapport sur la transparence et de vous montrer à quoi ressemble la prise de décisions difficiles sur une plateforme de plus de 250 millions d'utilisateurs inscrits.

Attendez, qu'est-ce qu'un rapport sur la transparence ?

Un rapport de transparence est un moyen pour nous de rendre visibles les rapports que nous recevons de nos utilisateurs sur les mauvais comportements sur la plate-forme et comment nous y répondons.

Nous croyons que la publication d'un rapport sur la transparence est un élément important de notre responsabilité envers vous --- c'est un peu comme les statistiques sur la criminalité d'une ville. Nous nous sommes donné pour objectif non seulement de vous fournir les chiffres que vous pouvez consulter, mais aussi de vous expliquer les obstacles auxquels nous faisons face tous les jours afin que vous puissiez comprendre pourquoi nous prenons les décisions que nous prenons et quels en sont les résultats.

**Pour commencer, voici quelques nombres **

L'équipe de confiance et sécurité reçoit plus d'un millier de rapports par jours et plus de sept mille rapports par semaines pour des violations de notre Charte d'utilisation. Ce rapport couvre les reports que Discord a reçus et les mesures prises du 1er janvier au 1er avril 2019 :

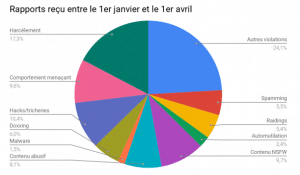

Au cours de ces trois mois, nous avons reçu un total d'environ 52 400 rapports. Lorsque les utilisateurs font des rapports, ils peuvent choisir parmis les catégories suivantes dans notre centre d'aide, présenté ici avec des exemples pour illustrer les questions que nous pouvons recevoir.

- **Harcèlement **: Un utilisateur crée à plusieurs reprises de nouveaux comptes pour envoyer des messages et insulter quelqu'un qui les a déjà bloqués ; les membres d'un serveur ciblent un utilisateur et continuent de lui envoyer des insultes raciales.

- **Comportement menaçant **: Un utilisateur menace un autre, que ce soit explicitement ("je vais vous tirer dessus") ou implicitement ("vous feriez mieux de faire attention ou quelque chose de mal va vous arriver")

- Hacks/Cheats : Un serveur vend des comptes volés pour des jeux populaires, ou distribue des cheats pour des jeux multijoueurs.

- Doxxing : Un utilisateur partage des informations personnelles d'un utilisateur tel que son adresse, son numéro de téléphone, l'adresse de son école, etc.

- Malware : Un utilisateur envoie en MP à un autre utilisateur un Cheval de Troie déguisé en un fichier patch de jeu afin de prendre le contrôle de leur ordinateur.

- Contenu abusif : Un utilisateur découvre que ses photos intimes sont partagées sans son consentement ; le flirt de deux mineurs mène au commerce d'images intimes entre eux.

- Contenu NSFW (Not Safe for Work) : Un utilisateur rejoint un serveur et envoie des MPs sanglants et des images violentes à d'autres membres du serveur.

- Automutilation : Un utilisateur est déprimé et décrit ne pas avoir un bon moment à l'école et ne pas avoir d'amis; un utilisateur est explicite au sujet de commettre un acte d'automutilation.

- Raiding : Un groupe d'utilisateurs coordonnent la connexion à un nouveau serveur, spamment les insultes et mentionnent @everyone en même temps, perturbant la discussion de cette communauté.

- Spamming : Un utilisateur --- ou plus probablement, un spambot automatisé --- rejoint un grand serveur puis envoie des MPs à tout le monde dans ce serveur contenant un site de rencontre de type "rencontre-quelqu'un-maintenant".

- Autres violations des Conditions d'utilisation : Les utilisateurs choisissent cette catégorie lorsqu'ils ne savent pas trop quoi choisir. Par exemple, un utilisateur tente de compromettre le compte d'un autre utilisateur, ou se fait passer pour un membre du personnel de Discord, ou peut-être que quelqu'un viole plusieurs Conditions d'utilisation à la fois.

Ces catégories ne sont pas coulées dans le béton. L'une des choses sur lesquelles nous continuons de travailler, c'est de nous assurer que les gens peuvent facilement présenter des rapports au besoin et qu'ils savent quels renseignements sont nécessaires pour mener une enquête. Nous cherchons actuellement à répéter ces catégories et à rendre les rapports plus intuitifs.

**Que se passe-t-il quand Discord reçoit un rapport ? **

L'équipe Confiance et Sécurité (Trust and Safety) enquête

À l'étape de l'enquête, l'équipe Confiance et Sécurité agit à titre de détectives, examinant les preuves disponibles et recueillant le plus d'information possible. Cette enquête est centrée sur les messages rapportés, mais peut s'étendre si les preuves montrent qu'il y a une violation plus importante - par exemple, si le serveur entier est dédié à un mauvais comportement, ou si le comportement semble s'étendre historiquement. Nous passons beaucoup de temps ici parce que nous croyons que le contexte dans lequel quelque chose est affiché est important et peut changer complètement le sens (comme si quelque chose est dit en plaisantant, ou est tout simplement du harcèlement).

Agir

Si ils peuvent confirmer une violation, l'équipe prend des mesures pour atténuer le préjudice. Voici les mesures que nous pouvons prendre sur les utilisateurs et/ou les serveurs :

- Suppression du contenu

- Avertir les utilisateurs pour les informer de leur infraction

- Bannir temporairement l'utilisateur de Discord pour une durée de temps déterminée

- Bannir définitivement l'utilisateur de Discord et faire en sorte qu'il soit difficile pour ce dernier de se recréer un nouveau compte

- Supprimer un serveur Discord

- Désactiver la capacité d'un serveur à inviter de nouveaux utilisateurs

Discord collabore également avec les organismes d'application de la loi en cas de danger immédiat et/ou d'automutilation.

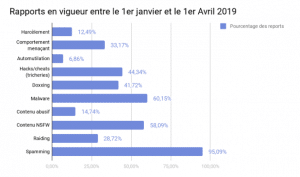

Répartition des rapports

Chaque fois que Confiance et Sécurité donne suite à un rapport, nous en tenons un registre. De plus, nous faisons le suivi du pourcentage de rapports sur lesquels nous prenons des mesures :

Note sur le graphique ci-dessus : bien que cela montre combien de fois nous avons pris des mesures dans chaque catégorie, les résultats ne sont pas toujours visibles pour le déclarant, et peuvent ne pas être le résultat que les utilisateurs attendent ou espèrent pour quand ils nous signalent des violations.

Parfois, un utilisateur fait un suivi pour demander quelles mesures nous avons prises, mais pour de nombreuses raisons, nous ne pouvons généralement pas communiquer ces détails. Par exemple, imaginez un scénario dans lequel un utilisateur a simulé son propre suicide pour mettre fin à une amitié sur Internet (c'est une situation réelle qui se produit étonnamment souvent). Leur ami inquiet nous rapporte les messages de cet utilisateur, mais au cours de notre enquête, nous déterminons que cette personne va parfaitement bien et bavarde avec leurs amis sur un autre compte Discord. Pour des raisons de confidentialité, nous ne pouvons pas partager cela avec la personne qui signale concernée. De leur point de vue, il semble que nous retenions des informations de vie ou de mort sur leur ami; du nôtre, nous croyons qu'il est correct de protéger la vie privée de nos utilisateurs (peu importe à quel point ils sont bien intentionnés).

Pourtant, certains de ces pourcentages semblent vraiment bas !

Il y a un certain nombre de raisons pour lesquelles un rapport pourrait ne pas donner l'impression qu'on y donne suite :

- Rapports faux ou malveillants : Parfois, les utilisateurs nous envoient des captures d'écran éditées ou suppriment leur moitié de la conversation, en espérant déformer les mots de quelqu'un d'autre hors contexte. D'autres fois, les utilisateurs se regroupent pour signaler un utilisateur innocent, en espérant que nous allons aveuglément les bannir, comme beaucoup d'autres plates-formes utilisent des systèmes qui suppriment automatiquement le contenu si il est rapporté assez de fois. Discord ne fait pas ça.

- Attentes déraisonnables : Nous pouvons recevoir un rapport de harcèlement au sujet d'un utilisateur qui a dit à un autre utilisateur : « Je déteste votre chien », et le reporter veut que l'autre utilisateur soit banni. Nous tenons toujours compte de la gravité du préjudice et de la possibilité de régler le problème au moyen d'outils de modération intégrés. Dans ces cas, il est très utile d'informer l'utilisateur sur comment gérer seul des expériences qui ne sont pas idéales. Être offensé n'est pas la même chose que d'être harcelé et nous pensons qu'il est important de faire la distinction entre les deux.

- Renseignements manquants : Nous demandons aux utilisateurs d'envoyer des liens de messages afin que nous puissions localiser l'infraction et enquêter sur le contexte. Malheureusement, nous recevons souvent des rapports où nous n'avons aucune preuve et où nous ne faisons que du ouï-dire. Étant donné que l'une de nos valeurs est de confirmer toute violation avant de prendre des mesures, nous n'agissons généralement pas en cas d'infraction avec des renseignements manquants.

- Rapports mal étiquetés : Bien que les utilisateurs puissent catégoriser leur rapport de façon incorrecte pour de nombreuses raisons, c'est habituellement parce que nos catégories sont larges et sujettes à interprétation (ce qu'un utilisateur considère comme du « doxxing » peut être considéré comme du « harcèlement » pour quelqu'un d'autre). Cependant, même si un rapport est mal étiqueté, nous continuons d'enquêter et d'examiner chaque rapport.

En fin de compte, de nombreuses mesures que nous prenons ne sont pas immédiatement évidentes pour le déclarant. Par exemple, lorsque nous bannissons un utilisateur ou supprimons un serveur, l'utilisateur déclarant n'est pas averti. En général, nous ne pouvons pas parler de mesures individuelles pour des raisons de protection de la vie privée, ce qui peut rendre difficile pour le reporter d'évaluer l'efficacité d'un rapport. De plus, n'importe lequel des scénarios ci-dessus fera en sorte qu'un rapport ne sera pas « traité » pour la catégorie dans laquelle il nous est présenté, ce qui explique pourquoi nos taux d'intervention ne disent pas toute l'histoire.

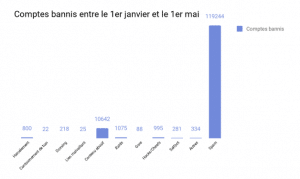

Comptes bannis lors des trois premiers mois de l'année 2019

Discord a banni les comptes suivants par catégorie en réponse aux rapports des utilisateurs et au travail proactif sur les violations des conditions d'utilisation :

Pour mettre les choses en perspective, les spams comptabilisent 89 % de tous les bannissements de compte et est plus de huit fois plus important que toutes les autres catégories de ban combinées.

Grâce aux ordinateurs intelligents et à l'automatisation, nous avons pu empêcher 100 000 robots spammeurs de s'inscrire quotidiennement. Nous améliorons également continuellement nos systèmes anti-spam.

De plus, nous avons consacré des ressources importantes au traitement proactif du contenu abusif, qui englobe la pornographie non consensuelle (pornographie de vengeance/ « faux profonds ») et tout contenu qui relève de la sécurité des enfants (ce qui comprend le matériel sur la violence sexuelle envers les enfants, les mineurs qui accèdent à du matériel inapproprié, et plus encore). Nous pensons qu'il est important de prendre une position très forte contre ce contenu, et bien que seulement environ quatre mille rapports de ce comportement nous aient été faits, nous avons pris des mesures contre des dizaines de milliers d'utilisateurs et des milliers de serveurs qui participaient à une forme quelconque de cette activité. L'équipe Confiance et Sécurité met fréquemment à jour et itère ses systèmes de détection de contenu nocif, notamment en travaillant avec d'autres entreprises à résoudre des problèmes similaires et en mettant en œuvre des systèmes tels que PhotoDNA afin de détecter ce contenu.

Parmi toutes les autres catégories, nous n'avons bannis que quelques milliers d'utilisateurs au total. Par rapport à nos 50 millions d'utilisateurs actifs mensuels, l'abus est assez faible sur Discord : seulement 0,003% des utilisateurs actifs mensuels ont été bannis. Si l'on tient compte des spambots, le nombre réel est dix fois plus faible, à 0,0003 %.

Appel

Chaque utilisateur peut faire appel des mesures prises contre ses comptes. Nous pensons que les appels sont une partie importante du processus. Tout comme vous méritez une chance d'être entendu lorsque des mesures sont prises contre vous dans un système judiciaire, vous devriez avoir une telle chance d'être entendu lorsque des mesures sont prises contre votre compte Discord.

Même si nous n'avons pas été en mesure de préparer le nombre d'appels interjetés et le nombre total d'appels accordés dans ce rapport sur la transparence, nous envisageons de l'ajouter dans des rapports futurs. Toutefois, lors d'une vérification récente portant sur un millier de bans pour cause de harcèlement au cours des trois premiers mois de 2019, seulement deux ont été annulées. Notre système, qui met l'accent sur l'examen manuel d'un contexte de messages, insiste sur le fait d'être confiant avant d'agir sur un compte, et nous nous attendons donc à ce que ce nombre soit assez faible. Nous ne sommes pas parfaits et des erreurs peuvent se produire même si nous faisons de grands efforts pour nous assurer de ne prendre des mesures que lorsque c'est justifié.

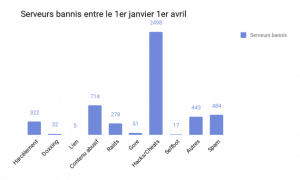

Serveurs supprimés au cours des trois premiers mois de 2019

Les comptes ne sont qu'une partie de l'histoire de Discord en raison de la façon dont Discord est structuré. La communication se fait entre les MPs et les serveurs.

Les comptes individuels peuvent être responsables de mauvaises activités, mais dans le cadre de nos enquêtes, nous prenons également des mesures lorsque des groupes d'utilisateurs violent collectivement nos Conditions d'utilisation communautaires avec un serveur dédié à ce contenu.

Entre janvier et avril 2019, Discord a supprimé le nombre suivant de communautés pour violation des Conditions de d'utilisation :

Plus de la moitié de tous les serveurs que nous avons supprimés étaient des communautés dédiées au partage des hacks et des tricheries de jeu, ou à la vente de comptes piratés.

Lorsque Discord supprime des serveurs, une chose sur laquelle nous nous concentrons est de réduire la propagation du mal de la force en nombre. Notre graphique montre que nous voyons le plus souvent cela comme un gameplay compromettant (affichage de triches, vente d'articles rares), mais nous recevons malheureusement aussi des rapports de serveurs axés sur la diffusion de discours haineux, harceler les autres et convaincre les autres de suivre des idéologies dangereuses.

Discord prend ces rapports au sérieux et supprime les serveurs présentant un comportement extrémiste. Nous adoptons une approche globale en examinant les rapports produits par les utilisateurs, ainsi qu'en collaborant avec les organismes d'application de la loi, des tiers (comme les médias et les universitaires) et des organisations axées sur la lutte contre la haine (comme la Anti-Defamation League et la Southern Poverty Law Center) pour nous assurer que nous sommes à jour et en avance sur les risques potentiels.

Ce que les chiffres ne montrent pas

Les chiffres sont essentiels à la transparence. Mais les chiffres ne disent pas toute l'histoire, et parfois ils ne reflètent pas les nuances de ce que signifie assurer la sécurité d'une plateforme.

C'était particulièrement vrai dans la soirée du 14 mars lorsque notre équipe de Confiance et Sécurité a commencé à recevoir des rapports selon lesquels une vidéo troublante et violente venait d'être diffusée en direct à Christchurch, en Nouvelle-Zélande. Au début, notre objectif premier était de supprimer la vidéo le plus rapidement possible, là où les utilisateurs l'ont partagée. Bien que nous ayons reçu moins de rapports sur la vidéo dans les heures qui ont suivi, nous avons constaté une augmentation du nombre de rapports sur le « contenu affilié ». Nous avons pris des mesures agressives pour supprimer les utilisateurs glorifiant l'attaque et imitant le tireur; nous avons pris des mesures sur les serveurs dédiés à la dissection du manifeste du tireur, serveurs à l'appui de l'agenda du tireur, et même des mèmes qui ont été faites et distribuées autour de la fusillade.

Notre équipe a travaillé jour et nuit pour examiner minutieusement chaque rapport, sensibiliser les utilisateurs sur les méfaits de ce contenu et supprimer tout contenu qui contrevient à nos lignes directrices communautaires. Au cours des dix premiers jours qui ont suivi cet horrible événement, nous avons reçu quelques centaines de rapports sur le contenu de la fusillade et avons émis 1 397 bannissements de compte aux côtés de 159 suppressions de serveurs pour des violations connexes.

Remarques finales

Nous vous remercions d'avoir pris le temps de consulter notre premier rapport sur la confiance et la transparence en matière de sécurité pour le début de 2019. Nous sommes conscients que ce sera peut-être beaucoup à digérer et que vous aurez peut-être des questions à vous poser, alors nous aimerions beaucoup vous entendre.

Nous croyons que la transparence envers les utilisateurs devrait être une norme parmi les entreprises de technologie et fournir des détails et des aperçus significatifs, afin que les gens puissent mieux déterminer comment les plateformes assurent la sécurité de leurs utilisateurs. Nous croyons que le fait de partager le plus possible incitera d'autres entreprises à faire de même. Plus nous pouvons faire de mal ensemble, plus nous nous rapprochons de l'élimination des méfaits d'Internet.

Comme nous l'avons mentionné, c'est la première fois que nous créons un rapport sur la transparence. À l'avenir, nous continuerons de répéter et d'améliorer ces rapports et nous envisageons de les publier régulièrement.

Enfin, ce n'est pas une mince tâche que de garder une plateforme de plus de 250 millions d'utilisateurs en sécurité pour notre petite équipe, et nous apprécions donc tous les rapports et tous les commentaires que nous recevons de notre communauté engagée. C'est motivant de savoir que vous êtes aussi passionné par la sécurité de Discord que nous.

Ceci est une traduction du blog Discord du post prénommé : Discord Transparency Report: Jan 1 --- April 1.