Rapport de Transparence Discord- Juillet à Décembre 2020

Anagram • Publié le 19 April 2021

traductionsArticle original : https://blog.discord.com/discord-transparency-report-july-dec-2020-34087f9f45fb

2020 était une année florissante pour Discord. Nous nous sommes sentis honorés d'accueillir autant de personnes sur notre plateforme durant la pandémie de COVID-19. L'équipe Trust & Safety de Discord a travaillé durement pour garder le rythme avec un nombre d'utilisateurs croissant. L'équipe était capable de répondre de manière significative à un haut nombre de rapports, tout en maintenant des efforts proactifs pour écarter de la plateforme les acteurs les plus dangereux. Nous avons également cherché à faire progresser la sécurité en ligne en formant des partenariats industriels plus étroits et en investissant dans des ressources communautaires telles que l'Académie de Modérateurs de Discord.

Aujourd'hui nous sommes heureux de finir notre rapport de 2020 avec les informations de l'autre moitié de l'année entre le 1er juillet et le 31 décembre 2020.

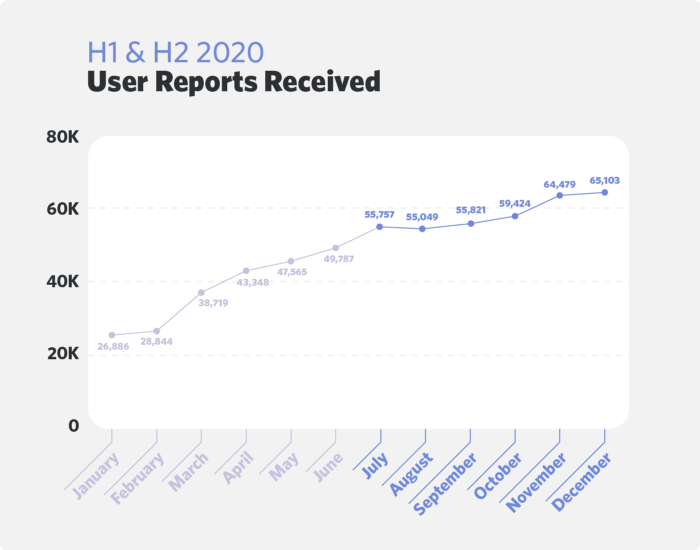

L'essor des rapports d'utilisateurs

En décembre 2020, nous avons annoncé que les 140 millions d'utilisateurs actifs mensuels trouvaient leur place sur Discord jusqu'à 100 millions en juin 2020. Parallèlement à l'expansion de la base d'utilisateurs, nous avons constaté une augmentation progressive, d'un mois sur l'autre, du nombre de rapports d'utilisateurs concernant des violations de nos règles communautaires. Cette croissance n'est pas due à un changement significatif dans l'une ou l'autre des catégories, mais plutôt à une tendance générale à la hausse des rapports dans toutes les catégories.

Trust & Safety a reçu un total de 355 633 rapports d'utilisateurs dans les six premiers mois qui séparent juillet de décembre en 2020. Cela représente une légère augmentation de 50 % depuis la première moitié de l'année. L'équipe recevait jusqu'à 30 000 rapports par mois, quelques mois avant la pandémie de COVID-19. Les totaux mensuels à la fin de 2020 étaient gonflés jusqu'à 60 000 presque 40 000 de plus par mois qu'au début de l'année.

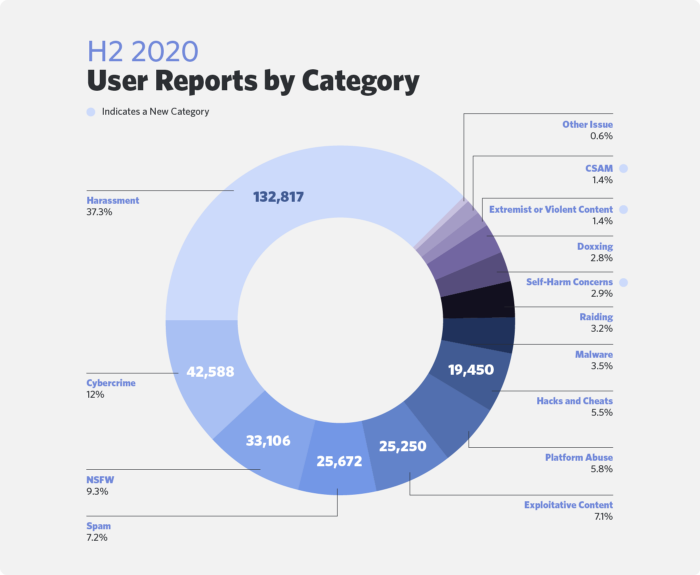

Les rapports reçus par catégorie

Le diagramme circulaire ci-dessus représente le nombre de rapports des utilisateurs entrants reçu par Trust & Safety dans la seconde moitié de 2020. Les totaux de ce graphique ne représentent pas le nombre de violations confirmées des règles communautaires de Discord, mais plutôt le nombre de rapports sur le contenu.

Le harcèlement continue à être le problème le plus rapporté sur la plateforme. La cybercriminalité est à l'origine du deuxième plus grand nombre de rapports au cours de la période avec une augmentation de 250 % depuis la première moitié de 2020. Le CSAM (Matériel d'Abus Sexuel d'Enfants) et les contenus violents ou extrêmes, qui ont tendance à être parmi les types de problèmes les plus dangereux, ont été beaucoup moins rapportés, chacun représentant légèrement plus d'un pourcent du volume total.

Le taux d'action pour les rapports d'utilisateurs

Trust & Safety utilise la désignation "actionné" lorsqu'il a confirmé une violation de nos règles de communautés et qu'il y a donné suite. Il peut s'agir d'un avertissement ou d'une suppression de compte ou de serveur, d'une interdiction temporaire de compte, d'un retrait de contenu de la plateforme, ou d'une autre action qui peut ne pas être immédiatement visible pour la personne qui soumet le rapport.

Le graphique ci-dessus nous montre que les types de problèmes les plus nuisibles ont généralement eu tendance à avoir des taux d'actions plus élevés par Trust & Safety. Cela pourrait être partiellement expliqué par l'établissement de priorités de problèmes par l'équipe en 2020 qui pourraient engendrer de vrais dommages dans le monde réel. Trust & Safety continue à assurer le fait que chaque rapport qui fait partie d'une catégorie à haut-risque soit revu et résolu en moins de 2 heures.

Les actions prises par Trust & Safety

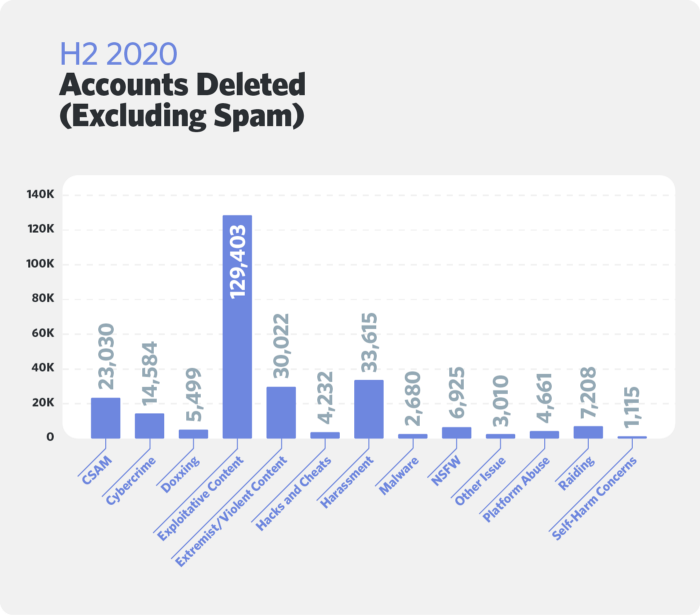

Suppressions de comptes

Notre approche de la modération du contenu consiste à prendre des mesures proportionnelles au niveau de préjudice. La suppression de comptes est généralement l'action la plus sérieuse que Trust & Safety peut prendre au niveau de l'utilisateur. Les utilisateurs peuvent être retirés de Discord pour avoir violé les règles de communautés ou pour avoir fait partie de groupes à haut risque qui enfreignent nos règles. Les suppressions sont permanentes sauf si l'utilisateur fait appel avec de nouveaux détails à propos des circonstances de son bannissement.

Le spam continue à être le plus gros cas de suppression de comptes. Trust & Safety et nos outils anti-spam ont retiré au total 3 264 655 comptes pour spam pendant cette période. Beaucoup de nos efforts dans cette seconde moitié de 2020 n'ont pas seulement concerné les suppressions de comptes, mais aussi le blocage et l'arrêt des spammeurs à l'inscription. Le spam au total a été exclu du graphique ci-dessus parce qu'il est beaucoup plus haut que tous les autres totaux qui ont entraîné une suppression.

Nous avons retiré 266 075 comptes qui ne faisaient pas de spam dans la seconde moitié de 2020 pour violation des règles de communauté. Le contenu exploitant a continué de compter pour le deuxième plus haut nombre de bannissements après le spam. Le CSAM ou les contenus violents et extrémistes, tout en représentant une part relativement faible du volume global des rapports, chacun a contribué à un haut nombre de comptes supprimés - résultant de nos efforts pour retirer ce contenu de notre plateforme.

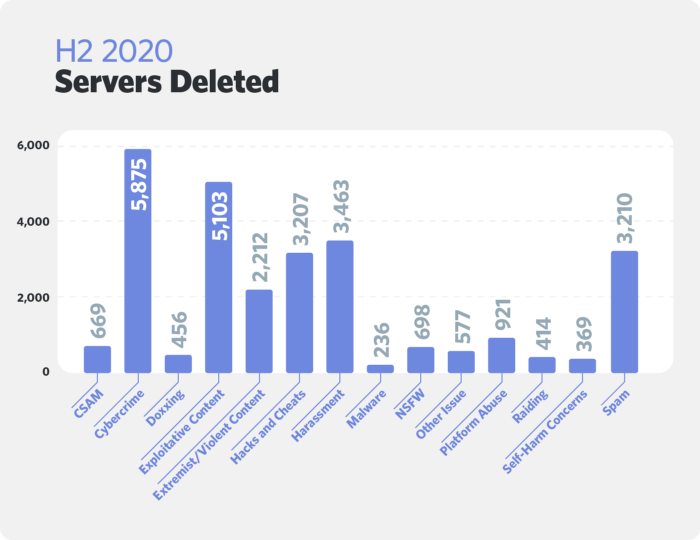

Suppressions de serveurs

Trust & Safety pourrait retirer un serveur de la plateforme s'il a un comportement ou du contenu qui enfreint nos règles de communauté. Les groupes les plus dangereux sont fréquemment supprimés avec les membres. Nous pouvons également retirer le serveur pour violations mineures répétées de nos règles de communauté ou si les modérateurs ne sont pas conformes après avoir reçu des avertissements au niveau du serveur.

Trust & Safety a retiré 27 410 serveurs entre juillet et décembre 2020 pour avoir enfreint ces règles. Les suppressions pour cybercriminalité et contenu exploitant ont été les plus fréquentes durant cette période.

Les suppressions de serveurs pour cause de cybercriminalité en particulier ont fait un bond de près de 140 % depuis la première moitié de 2020. Cela correspond à l'augmentation marquée des rapports plus d'espaces de cybercriminalité que jamais ont été signalés à Trust & Safety, et bien plus ont été retirés de notre site. Pendant que le contenu exploitant est légèrement plus bas que depuis la première moitié de 2020, c'est uniquement parce que nous avons précédemment déclaré le CSAM comme faisant partie de cette catégorie.

Les suppressions dans presque toutes les autres catégories ont augmenté depuis la seconde moitié de 2020. La seule exception est celle des Hacks & Cheats. Les rapports et suppressions de ces deux-là ont significativement baissé depuis la première moitié de l'année. Les hacks et les cheats sont toutefois restés deux des raisons les plus courantes de la suppression des serveurs entre juillet et décembre 2020.

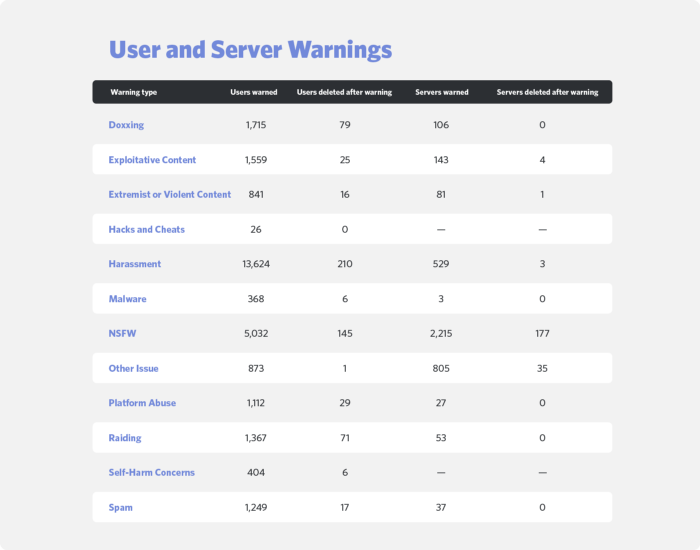

Avertissements d'utilisateurs et de serveurs

Nous avons continué à utiliser les avertissements comme un moyen de corriger les utilisateurs et les serveurs responsables pour qu'il y ait moins de violations des règles de communauté. La décision d'utiliser un avertissement plutôt qu'une suppression permanente n'est généralement prise que si le comportement ne cause que peu de tort et si le contexte suggère que la partie en infraction a le potentiel de se réformer. Pendant que certains utilisateurs et serveurs continuent à enfreindre les règles de Discord après avoir reçu un avertissement et plus tard supprimés la majorité est capable de se calmer sur la plateforme sans qu'il n'y ait aucune autre intervention future.

Trust & Safety a recensé 28 170 avertissements d'utilisateurs dans la seconde moitié de 2020 et avec cela 3 999 avertissements de serveurs. Nous ne donnons pas d'avertissements pour le CSAM ou la cybercriminalité au niveau de l'utilisateur ou du serveur et nous n'avertissons pas les serveurs pour Hacks & Cheats ou préoccupations relatives à l'automutilation. Les violations de ces catégories sont généralement assez sévères pour éviter la suppression immédiate.

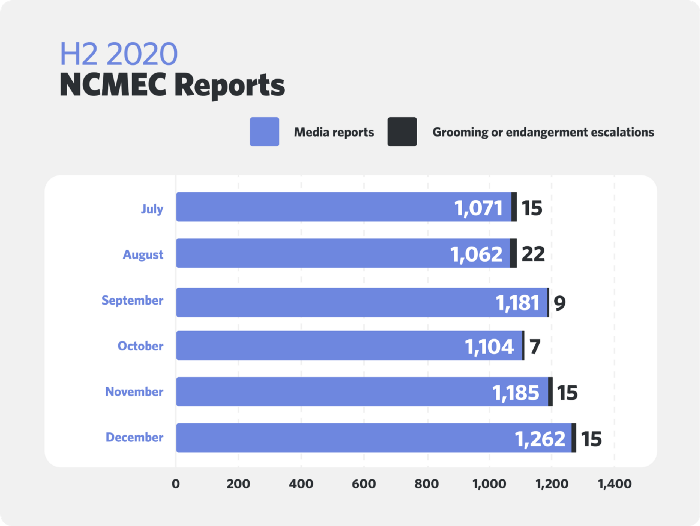

Rapports de NCMEC

Discord ne tolère pas le contenu qui exploite sexuellement les enfants. Les utilisateurs qui sont retrouvés en train de partager un tel contenu sont signalés au NCMEC (Centre National des Enfants Disparus et Exploités) et retirés de la plateforme. Tout le matériel destiné aux enfants est immédiatement supprimé de Discord. Nous avons fréquemment fait une enquête et nous avons rapporté les cas plus graves de prédation sexuelle ou de mise en danger.

Nous avons rapporté 6 948 comptes au NCMEC pendant la seconde moitié de 2020. Cela représente certains comptes signalés mais en aucun cas le nombre total de rapports recensés.

La majorité de nos rapports ont été en rapport avec les images incluant des abus sexuels d'enfants qui ont été signalés au logiciel de hashing PhotoDNA. Trust & Safety vérifie toutes les images signalées et signale les cas confirmés de contenu portant atteinte aux enfants. Ces totaux sont représentatifs de "rapports de Médias" dans le graphique présenté ci-dessus.

Par ailleurs, 83 de nos rapports concernaient des situations de prédation sexuelle ou de mise en danger plus graves. Trust & Safety enquête de manière approfondie sur tous les cas qui pourraient entraîner un préjudice immédiat pour un mineur. Nous travaillons en étroite collaboration avec le NCMEC pour garantir que les cas urgents reçoivent une attention rapide.

Suppression proactive de serveurs

Nous avons continué à investiguer sur les ressources de la seconde moitié de 2020 pour proactivement détecter et retirer les groupes nocifs de notre plateforme. La plupart des efforts proactifs de Trust & Safety sont allés jusqu'à retirer des espaces partageant du contenu exploitant et des groupes violents extrémistes.

Contenu exploitant

La catégorie générale des contenus exploitants comprend deux sous-catégories : pornographie non-consensuelle (NCP) et le contenu sexualisé de mineurs (SCRM). SCRM se distingue ici du CSAM en ce que ces espaces pourraient sexualiser les mineurs sous des formes moins explicites mais toujours violentes.

Nous avons proactivement supprimé 1 919 serveurs de contenu exploitant dans la seconde moitié de 2020. Pendant que nous pouvions supprimer un peu plus de serveurs NCP au cours de la seconde moitié de 2020, le nombre de suppressions proactives de SCRM a baissé pour la première fois en passant sous le nombre de suppressions de serveurs réactifs. Il convient de noter, cependant, que les suppressions globales de SCRM restent plus élevées que le nombre de suppressions de NCP ou d'extrémisme violent.

Nous sommes déçus que pendant cette période, l'un de nos outils pour la détection proactive de serveurs SCRM contenait une erreur. Il y a donc eu moins de signalements à notre équipe. Cette erreur a depuis été résolue et nous avons repris l'enlèvement des serveurs des surfaces d'outils.

L'extrémisme violent

Nous avons également travaillé pendant la seconde moitié de 2020 pour agir contre les mouvements militarisés comme les "Boogaloo Boys" et ces groupes conspirationnistes dangereux comme QAnon. Nous continuons de croire qu'il n'y a pas lieu sur Discord pour les groupes qui s'organisent autour de la haine, la violence, ou les idéologies extrémistes.

Trust & Safety a supprimé de manière proactive 1 504 serveurs pour de l'extrémisme violent au cours du second semestre de 2020, soit une augmentation de près de 93 % par rapport au premier semestre de l'année. Cette augmentation peut être attribuée à l'expansion de nos efforts anti-extrémistes ainsi qu'aux tendances croissantes dans l'espace de l'extrémisme en ligne. L'une des tendances en ligne observées au cours de cette période a été la croissance de QAnon. Nous avons adapté nos efforts pour faire face à ce mouvement, en supprimant finalement 334 serveurs liés à QAnon.

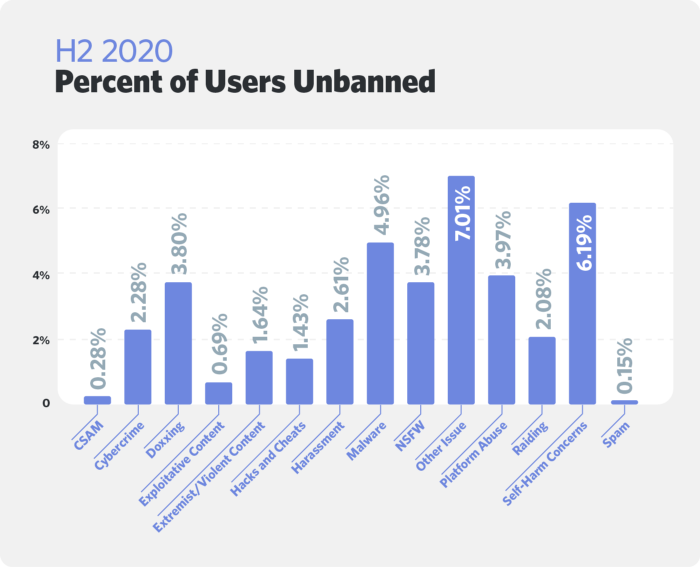

Le processus d'appel au bannissement

Les utilisateurs qui ont été retirés de Discord ont la possibilité d'écrire à Trust & Safety et faire appel sur l'action qui avait été prise sur leur compte. Nous examinons l'appel de l'utilisateur et pouvons annuler une décision si de nouveaux détails à propos du bannissement sont présentés ou si nous découvrons une erreur dans notre travail. Trust & Safety ne s'engagera pas dans les appels qui présentent des problèmes de sécurité.

Nous avons reçu 82 166 appels d'utilisateurs non-spammeurs au cours du second semestre de 2020, contre environ 70 000 au cours du premier semestre de l'année. Ces utilisateurs cherchaient chacun à annuler l'une des 266 075 suppressions prononcées par Trust & Safety. Nous avons annulé notre décision dans 3 937 cas, ce qui correspond à un taux de débanissement d'environ 1,5 %. Nous avons accordé 3 061 appels supplémentaires pour des utilisateurs supprimés pour spam.

Un regard plus approfondi de 3 appels de bannissement

Vous trouverez ci-dessous trois exemples de cas pour mieux illustrer la manière dont Trust & Safety aborde la procédure d'appel des interdictions. Les informations d'identification ont été supprimées pour respecter la vie privée des utilisateurs.

Étude de cas n° 1 : suppression de comptes pour harcèlement ciblé

Trust & Safety a supprimé le compte d'un utilisateur dans le cadre d'un démantèlement plus large de serveurs impliqués dans le harcèlement ciblé et l'incitation à la violence. L'utilisateur a publiquement commenté l'interdiction sur d'autres plateformes de médias sociaux et a été conseillé d'écrire à notre file d'attente d'assistance.

Résultat : Notre raison de supprimer un utilisateur ou un serveur de Discord ne serait pas toujours claire au public. Trust & Safety a étroitement revu l'appel de bannissement de cet utilisateur et a confirmé ses violations des règles de communauté. Nous avons décidé de ne pas réintégrer le compte.

Étude de cas n° 2 : suppression de compte extrémiste

Trust & Safety a supprimé un serveur et tous ses membres pour avoir promu des idéologies extrémistes. Un utilisateur qui a été impacté par le bannissement a déclaré la raison pour laquelle ils se trouvaient dans cet espace. Ces derniers ont affirmé être en train d'apprendre la radicalisation en ligne et clarifié qu'ils n'avaient pas promu d'idéologies extrémistes.

Résultat : Nous avons investigué et confirmé que l'utilisateur ne présentait pas de risque sur Discord. Trust & Safety a annulé le bannissement mais a averti l'utilisateur qu'il ne devait pas adopter ce comportement. Nous n'autorisons pas l'extrémisme et nous conseillons à tous les utilisateurs de signaler les espaces potentiellement dangereux.

Étude de cas n° 3 : Bannissement temporaire du compte

Un utilisateur a écrit à Trust & Safety après avoir reçu un avertissement et un bannissement temporaire d'une journée pour avoir menacé des membres. Ils ont reconnu la raison de l'avertissement et promis d'être plus respectueux.

Résultat : En général, nous ne mettons pas en place de bannissement temporaire. Trust & Safety a estimé que la journée de bannissement temporaire était proportionnelle au niveau de nocivité, et a informé l'utilisateur qu'il pourrait reprendre accès sur Discord le jour suivant. L'utilisateur à ce moment était autorisé à retourner sur Discord.

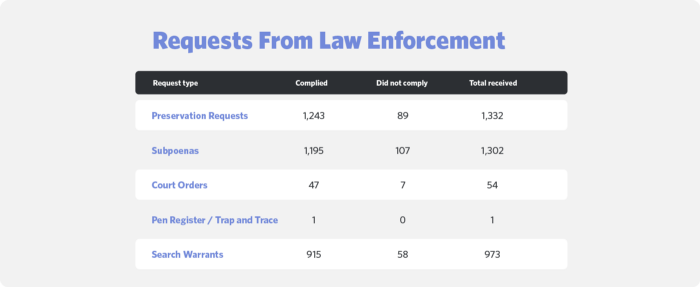

Demandes des forces de l'ordre

Discord a une obligation légale de répondre aux demandes d'application de la loi américaine visant à obtenir des informations sur les utilisateurs qui pourraient être l'objet d'une enquête criminelle. Tous les éléments de la procédure légale sont soumis à un examen rigoureux de la part de notre équipe des opérations juridiques, afin de s'assurer qu'ils sont légalement suffisants. Discord peut contester les demandes qui ne sont pas claires, qui vont trop loin ou qui ne sont pas légalement valables.

Nous avons reçu 3 662 demandes de procédure judiciaire au total pendant les 6 mois qui ont séparé juillet et décembre 2020. Ces nombres incluent les requêtes que nous avons reçues avec le processus de Traité d'Assistance Judiciaire Mutuelle (MLAT). Discord a besoin que toutes les requêtes légales des agences de gouvernements étrangers soient délivrées avec des procédures MLAT.

3 401 requêtes de processus légal ont été retenues comme valide signifiant qu'elles étaient délivrées et signées par une autorité légale, et ont également fourni assez d'informations pour que nous puissions identifier un utilisateur.

Demandes de divulgation d'urgence

Discord pourrait révéler les informations d'utilisateurs pour le respect de la loi sans processus légal dans les cas urgents où la menace est importante. Le respect de la loi peut suivre ces étapes s'ils pensent qu'il y a une urgence avec l'un de nos utilisateurs qui pourrait entraîner la mort ou des blessures physiques graves. Nous ne divulguons pas d'informations à l'application de la loi en l'absence de procédure légale tant que nous n'avons pas fini d'investiguer et de confirmer une croyance de bonne foi qu'une blessure physique résulte sans notre action.

Nous avons reçu 325 requêtes pour des divulgations d'urgence de l'application des lois au niveau mondial dans les 6 mois entre juillet et décembre 2020. Nous avons fait des divulgations pour 122 de ces cas. Soit nous ne pouvions pas en identifier, soit nous n'avions pas divulgué d'informations sur les utilisateurs dans les autres cas.

La force par les partenariats

Nous avons énormément profité, au cours des six derniers mois, du rapprochement des partenariats avec les leaders de l'industrie, les agences de gouvernement, les groupes de sociétés civiles et académies. Nous avons rejoint l'Association Professionnelle de Trust & Safety pour étendre le développement professionnel de l'équipe de Trust & Safety de Discord ; et, aux côtés de Google, Facebook, Microsoft, Pinterest et Reddit, était un membre fondateur du Partenariat pour la confiance et la sécurité numériques.

Nous avons établi un partenariat avec la Technology Coalition, la Family Online Safety Institute, et le ConnectSafely pour renforcer notre engagement pour éviter l'abus d'enfants en ligne. Nous avons aussi rejoint la Tech Against Terrorism et le Global Internet Forum to Counter Terrorism pour étendre notre capacité à identifier et retirer les groupes extrémistes et violents de notre plateforme. Nous sommes impatients d'approfondir ces partenariats en 2021 et d'en conclure d'autres pour faire progresser la sécurité en ligne.

. . .

Nous considérons ces rapports semestriels comme des occasions précieuses de partager des informations sur les opérations de l'entreprise qui ont un impact direct sur nos utilisateurs. Nous espérons que les données de plus en plus claires et granulaires présentées ici permettent de dresser un tableau plus complet du travail que nous accomplissons pour assurer la sécurité de Discord.

Trust & Safety travaille dur en 2021 pour s'assurer que tous les utilisateurs concernés reçoivent des réponses rapides et appropriées. L'équipe continue également à s'investir dans des méthodes de détection proactive d'abus donc nos utilisateurs sont protégés de tout contenu nocif. Nous espérons également renforcer l'autonomie des modérateurs en investissant dans des ressources telles que la Discord Moderator Academy. Nous sommes impatients de relever le défi de la modération de contenu à grande échelle.