Rapport de transparence Discord : Avril – Décembre 2019

MemerK • Publié le 30 April 2020

traductionsUne note de Jason et Stan

Nous avons créé Discord en 2015 pour rassembler les gens autour de jeux, et il est étonnant de voir les différentes façons dont les gens l'utilisent aujourd'hui pour parler avec leurs amis et leurs communautés.

Cependant, avec des dizaines de millions de personnes actives sur Discord chaque jour, la lutte contre les contenus inappropriés et les comportements malveillants exige de la vigilance, tant de notre part que de celle de nos utilisateurs. Alors que l'équipe Trust & Safety rend la vie difficile aux mauvais acteurs, nos utilisateurs jouent leur rôle en signalant les violations - montrant ainsi qu'ils se soucient de cette communauté autant que nous.

L'année dernière, nous avons publié notre tout premier rapport de transparence, qui donne un aperçu détaillé du travail que nous accomplissons pour garantir une expérience sûre et positive sur Discord. En continuant à investir dans la confiance et la sécurité et en améliorant nos capacités de mise en œuvre, nous aurons de nouvelles idées et de nouveaux enseignements à partager. Le prochain rapport sera publié en août, alors que nous passons à une cadence semestrielle.

Résumé

Le nombre d'utilisateurs de Discord a augmenté de manière significative en 2019, et nous avons également constaté une augmentation des signalements au cours de l'année. Nous en avons reçu environ 176 000 au cours des neuf derniers mois, ce qui représente une augmentation mensuelle moyenne de 12 % par rapport aux trois premiers mois.

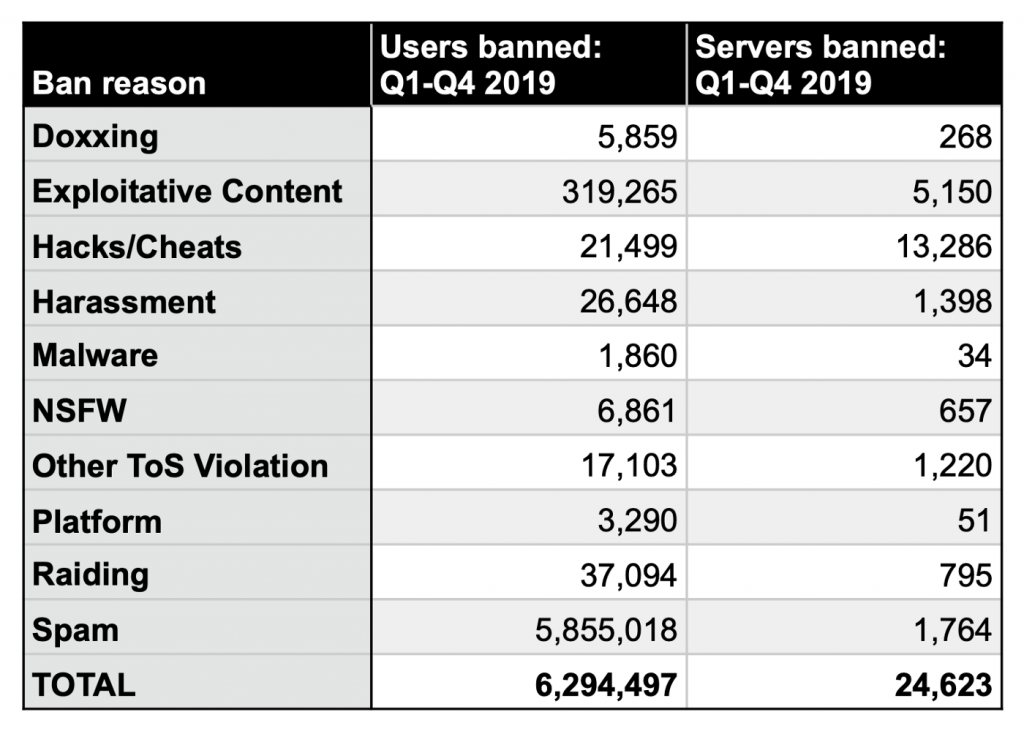

Notre équipe Trust & Safety s'est également agrandie en 2019, et nous avons pris plus de mesures d'application qu'auparavant. Discord a banni environ 5,2 millions de comptes d'avril à décembre 2019 - la grande majorité d'entre eux pour du spam - et supprimé près de 20 000 serveurs. Bien que cela puisse sembler être une augmentation considérable par rapport à notre dernier rapport, cela est largement dû à un changement dans la méthodologie des rapports que nous détaillons ci-dessous.

Enfin, nous avons également pu retirer une majorité de serveurs responsables des pires contenus d'exploitation et d'extrémisme avant que les spectateurs n'aient à les rencontrer, eux ou leur contenu.

Rapports reçus

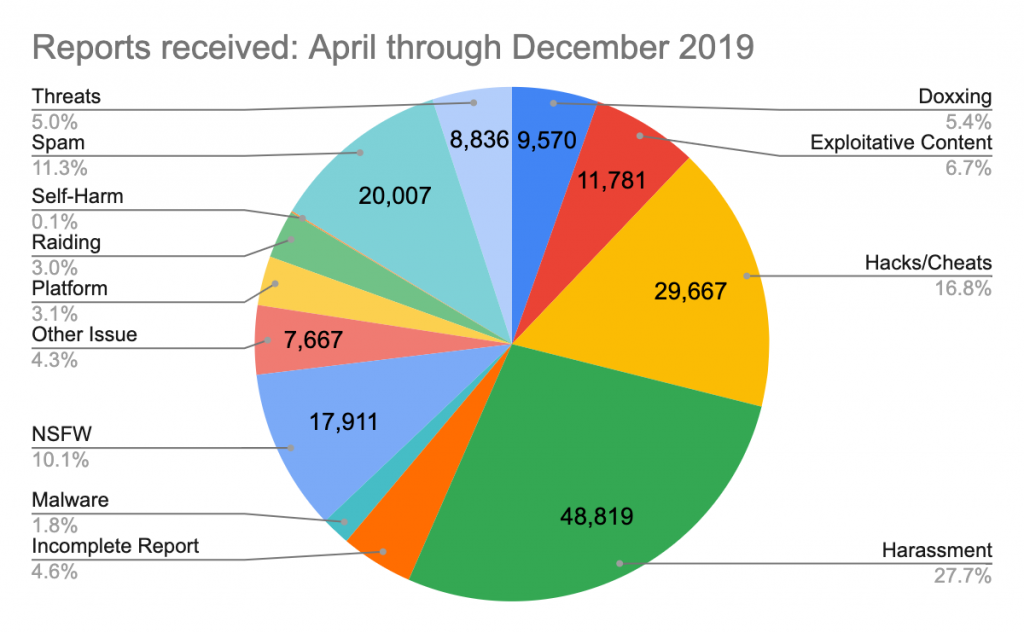

L'équipe confiance et sécurité passe une grande partie de son temps à répondre à vos signalements. Nous encourageons les personnes à signaler toute activité qui, selon elles, enfreint nos règles communautaires ou nos conditions de service, et nous examinons chaque rapport de manière approfondie. Ce tableau présente la répartition des 176 000 rapports que nous avons reçus par type de violation :

Vous remarquerez peut-être que la répartition des catégories dans le graphique ci-dessus est un peu différente de celle de l'année dernière. La catégorie « Autre problème » a diminué, en partie parce que nous avons ajouté deux nouvelles catégories, « Rapport incomplet » et « Plateforme », pour fournir plus de détails et de contexte. De manière générale, les violations de plateforme impliquent un comportement qui abuse de notre API, comme la création d'un selfbot ou le spam de notre API avec des demandes non valides. Les rapports incomplets font référence à des situations où il n'y avait pas suffisamment d'informations pour déterminer si une violation avait eu lieu. Aucune action n'a donc été entreprise.

Répondre aux rapports

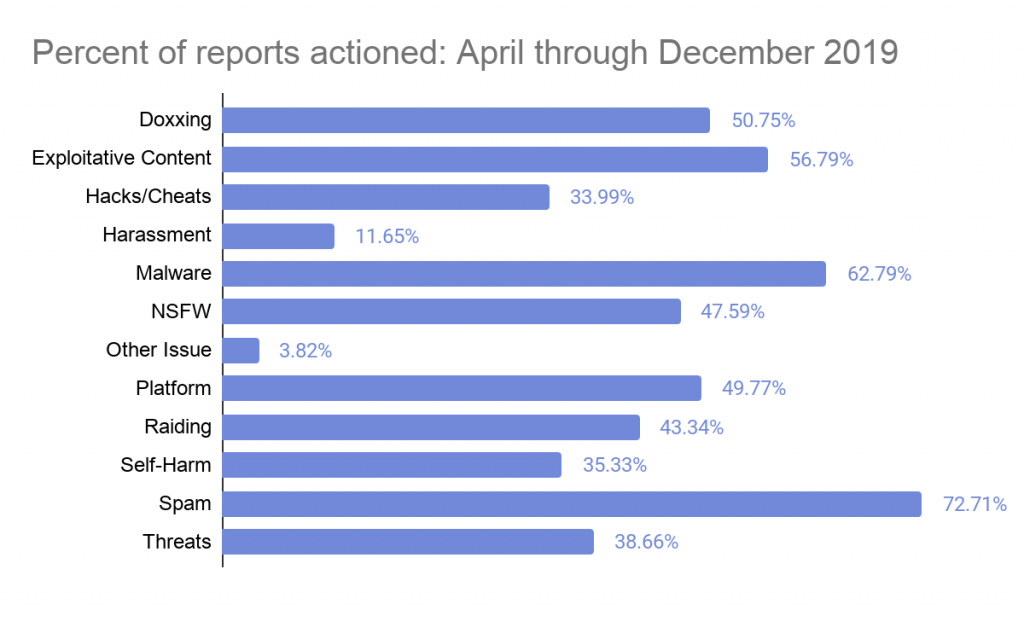

Le graphique ci-dessous montre comment nous avons répondu à chaque rapport d'avril à décembre de l'année dernière. (Pour plus d'informations sur les taux d'action et leur signification, consultez le premier rapport de transparence.)

Les taux d'action les plus élevés se produisent généralement lorsque le degré de vérifiabilité est élevé et que le problème affecte de nombreuses personnes, comme le spam ou les logiciels malveillants. De même, s'il s'agit d'un conflit interpersonnel entre deux personnes, les taux d'action ont tendance à être plus bas car les faits sont souvent difficiles à vérifier. Il convient également de noter que dans des cas tels que les signalements d'automutilation, la mise en danger d'enfants ou des dommages imminents, « agir » peut signifier escalader les autorités en dehors de Discord.

Vous remarquerez que le taux d'action des signalements de harcèlement est relativement faible. En effet, le harcèlement est une vaste catégorie qui comprend les mauvais comportements de différents types et niveaux de gravité, dont certains peuvent être arrêtés simplement en bloquant un utilisateur ou en les interdisant d'un serveur. Par exemple, nous recevons des rapports de nouveaux utilisateurs sur la façon dont une personne utilisant un langage grossier les harcèle. Dans ces cas, nous les informerons de la fonction de blocage, mais nous ne prendrons aucune mesure sur l'utilisateur signalé.

D'un autre côté, le taux d'action pour doxxing - publier des informations personnellement identifiables - est assez élevé. Nous prenons ces rapports très au sérieux et s'ils sont confirmés, nous bannissons presque toujours le contrevenant, en plus de supprimer le contenu. Les rapports sur les logiciels malveillants et les spams affichent également des taux d'action assez élevés, en partie parce qu'il n'y a pas beaucoup de zone grise dans ce que cela représente.

Bannissement d'utilisateurs

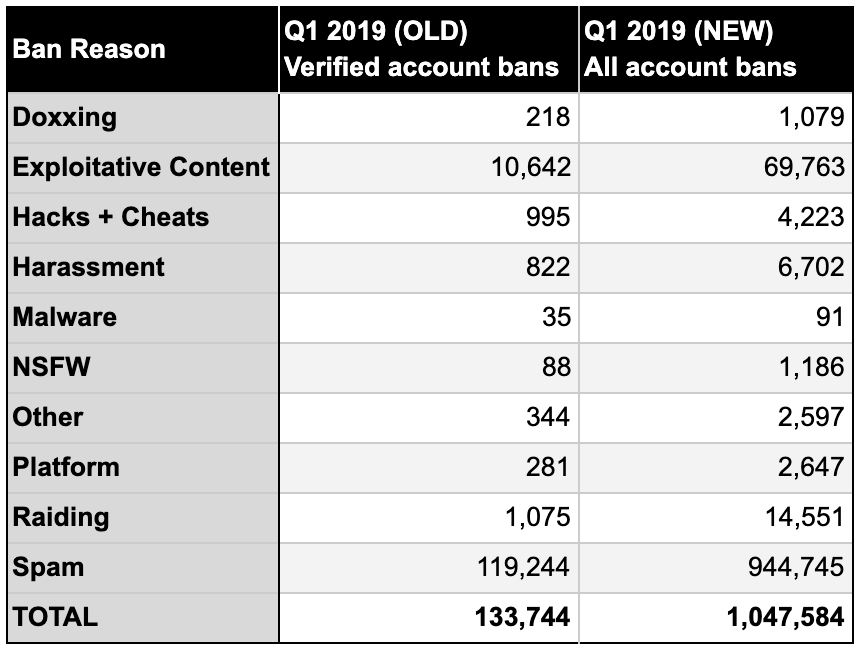

Dans notre premier rapport de transparence, nous n'avons indiqué que des bannissements d'utilisateurs avec une adresse e-mail vérifiée. En effet, le fait d'avoir un compte non vérifié indique souvent qu'il s'agit d'un compte jetable ou dupliqué utilisé par de mauvais acteurs. Cependant, comme indiqué dans la section Résumé ci-dessus, nous modifions la méthodologie de déclaration et, à l'avenir, nous signalerons le total des bannissements de comptes. Pour être totalement transparent et pour faciliter la comparaison historique des chiffres, voici les chiffres des bannissements de notre premier rapport utilisant la nouvelle méthodologie :

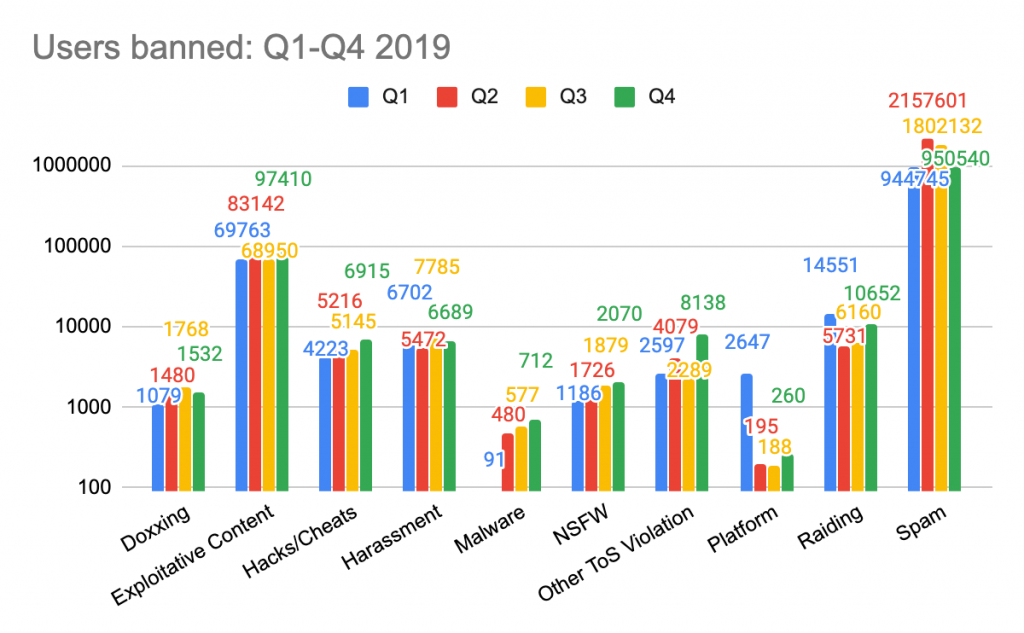

Nous pouvons maintenant fournir un aperçu plus complet de 2019. Dans ce graphique, nous avons regroupé les bannissements par catégorie et les avons suivies au cours des quatre derniers trimestres.

Vous remarquerez que ce graphique utilise une échelle logarithmique, car le spam est une catégorie tellement énorme par rapport à tout le reste. Au cours des neuf derniers mois, près de quatre millions de spambots ont été bannis et supprimés de la plateforme, principalement par nos filtres anti-spam. Pourtant, les spammeurs font constamment évoluer leur comportement et nous investissons davantage dans les ressources pour les rattraper. En fin de compte, nous ne pensons pas que les gens devraient consacrer du temps à contrer le spam ou à essayer de se protéger contre lui.

Le deuxième type de bannissement d'utilisateurs est le contenu d'exploitation. Nous reviendrons plus en détail sur cette catégorie un peu plus tard, car nous avons fait un effort agressif pour supprimer tous les utilisateurs qui adoptent ce comportement.

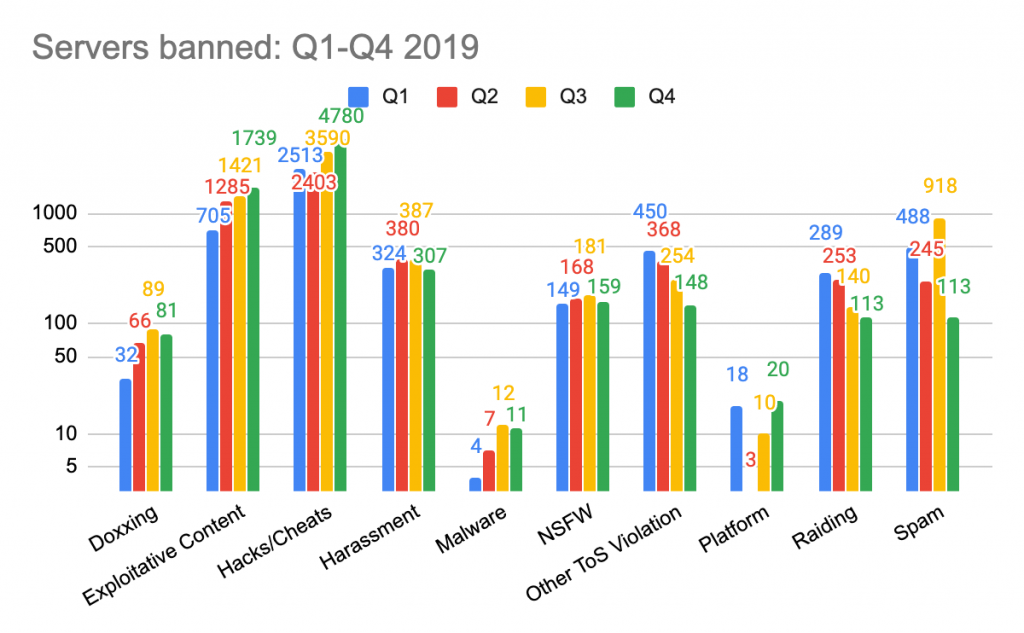

Bannissement de serveurs

En plus de prendre des mesures sur des utilisateurs individuels, nous pouvons également bannir les serveurs qui enfreignent nos conditions ou directives :

Accent accru sur l'application proactive

Répondre aux rapports des utilisateurs est une partie importante du travail de l'équipe Trust & Safety, mais nous savons qu'il y a également une violation du contenu sur Discord qui peut ne pas être signalé. C'est là que nos efforts proactifs entrent en jeu. Notre objectif est d'arrêter ces mauvais acteurs et leur activité avant que quiconque ne les rencontre. Nous accordons la priorité à l'élimination du contenu le plus nuisible parce qu'il n'a absolument aucune place sur Discord et parce que le risque de préjudice est élevé.

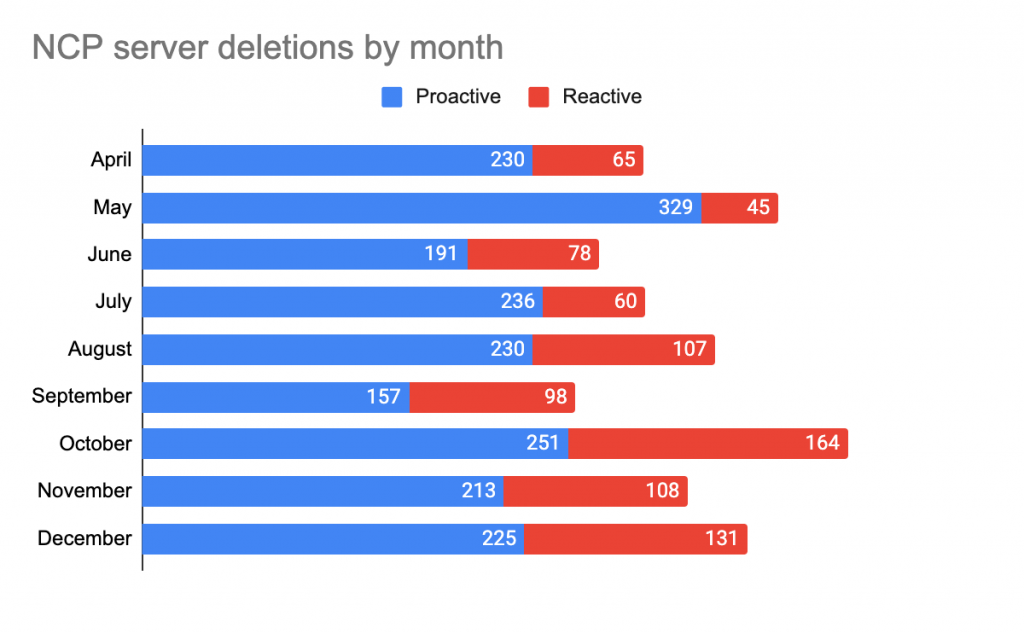

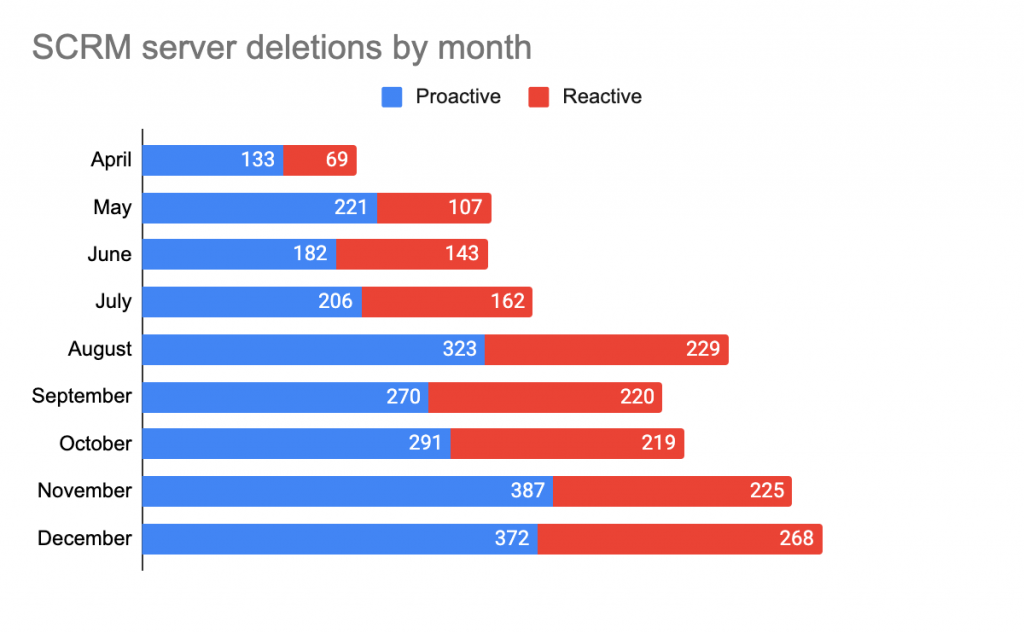

Le contenu exploitable est un objectif majeur de notre travail proactif, plus spécifiquement la pornographie non consensuelle (PNC), où les photos intimes sont partagées en tant que « porno de vengeance » (« revenge porn ») et le contenu sexuel lié aux mineurs (CSLM). Nous avons une politique de tolérance zéro pour cette activité et lorsque nous la trouvons - par des moyens réactifs ou proactifs - nous la supprimons immédiatement, ainsi que tous les utilisateurs et serveurs partageant le contenu. Dans les cas impliquant du matériel d'abus sexuel d'enfants, nous signalons rapidement le contenu et les utilisateurs au Centre national pour les enfants disparus et exploités.

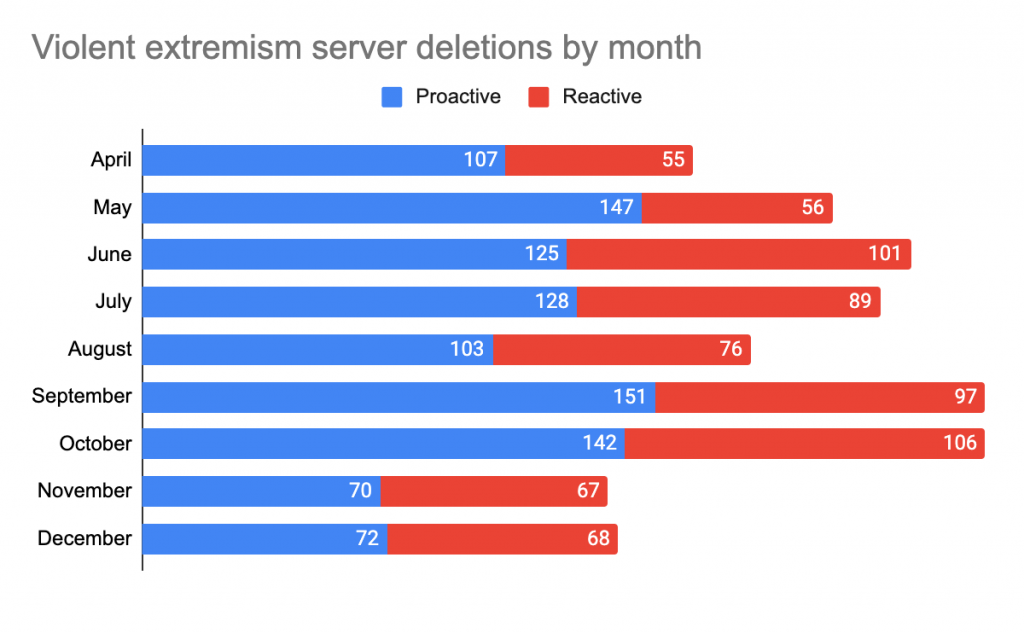

L'extrémisme violent est un autre domaine prioritaire de l'application proactive de la loi, où nous continuons de prendre des mesures agressives à la fois contre les groupes et les individus. L'extrémisme violent, en terme général, est un contenu dans lequel les utilisateurs préconisent ou soutiennent la violence comme moyen d'atteindre une fin idéologique. Les exemples incluent les groupes violents à motivation raciale, les groupes à motivation religieuse voués à la violence et les groupes incels.

Alors, qu'est-ce que le travail proactif implique ? Nous ne lisons pas de manière anticipée le contenu des messages privés des utilisateurs - la confidentialité est extrêmement importante pour nous et nous essayons de trouver un équilibre réfléchi avec notre devoir de prévenir les dommages. Cependant, nous numérisons 100% des images et des vidéos téléchargées sur notre plateforme à l'aide de PhotoDNA standard pour détecter les correspondances avec le matériel connu d'abus sexuel d'enfant. Lorsque nous trouvons quelqu'un qui s'engage dans ce type d'activité, nous enquêtons sur ses réseaux et son activité sur Discord pour découvrir de manière proactive des complices ou d'autres sources de contenu.

Voici les résultats de notre travail proactif d'avril à décembre 2019 :

Dans ces trois domaines, plus de la moitié des serveurs ont été supprimés sans que des tiers aient visualisé leur contenu. En moyenne, environ 70% des serveurs PNC ont été supprimés avant d'être signalés, et près de 60% des serveurs SCRM et extrémistes ont été bannis de manière proactive. Nous nous engageons à consacrer encore plus de ressources pour ces efforts proactifs.

Le processus d'appel

Aucun système n'est parfait, et même si notre équipe est convaincue que nous avons pris les bonnes mesures, il peut y avoir des circonstances atténuantes ou des informations qui n'étaient pas disponibles à l'origine. En conséquence, chaque action prise sur un compte peut être contestée par l'utilisateur.

Lors de l'examen d'un appel, l'équipe Trust & Safety examine le rapport d'origine et prend en compte la gravité de la violation actuelle et de toute violation antérieure par l'utilisateur ou le serveur. Il convient de noter que la plupart des utilisateurs qui réussissent à faire appel expriment des remords, assument leurs responsabilités ou fournissent une explication plus approfondie de ce qui s'est passé.

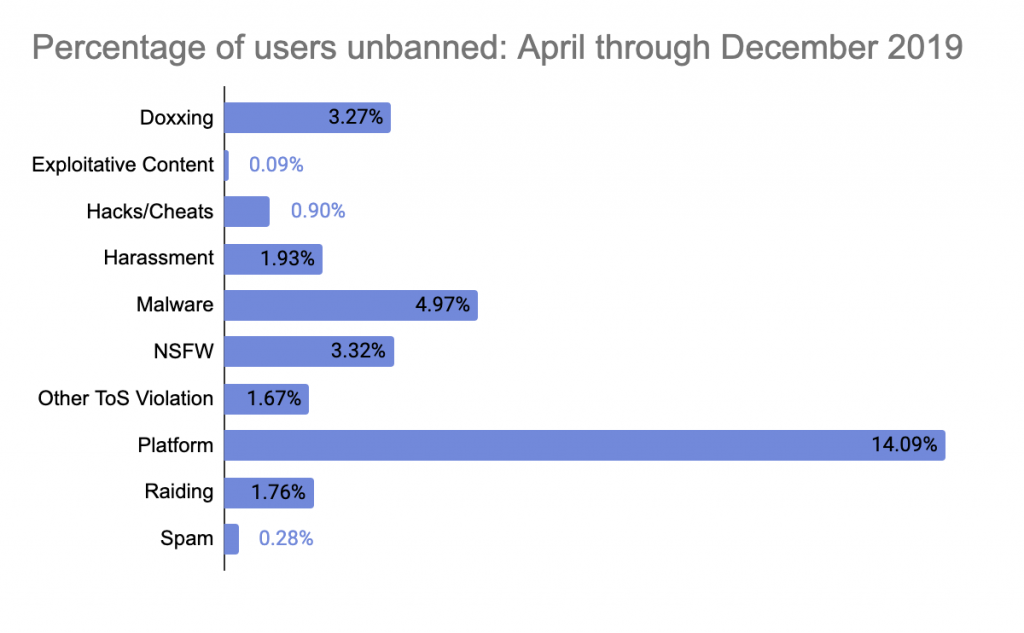

Entre avril et décembre 2019, nous avons banni plus de 5,2 millions de comptes, et un peu moins de 16 000 d'entre eux ont été rétablis en appel. Voici un détail du taux de bannissements révoqués par catégorie :

La valeur aberrante dans la catégorie unban correspond aux violations de plateforme. Cela est largement dû aux cas où les utilisateurs ont (sciemment ou inconsciemment) créé un selfbot. Il est courant que les gens ne sachent pas que cela enfreint nos conditions, nous sommes donc souvent disposés à donner aux utilisateurs qui font appel le bénéfice du doute.

Enfin

Chaque acte malveillant sur Discord en est un de trop. Nous voulons que Discord soit accueillant pour tout le monde, et nous promettons de faire notre part en travaillant de manière agressive pour entraver les mauvais comportements avant qu'ils ne se produisent, tout en respectant la vie privée des gens.

En 2020, vous pouvez vous attendre à une transparence continue de la part de Discord. Merci de nous faire confiance et d'avoir choisi de construire votre communauté ici.